Sui social molti postano da anni foto personali. Ora può diventare rischioso: una nuova tecnologia di generazione di immagini con l’Intelligenza Artificiale, permette a chiunque di salvare foto e poi istruire l’I.A. per creare dei realistici fake.

Anche se non è detto che capiti a tutti, è meglio saperlo. Nel seguito traduco sul tema una parte del lungo articolo di Ars Technica, che descrive come è possibile creare “foto false realistiche che vi mostrano mentre fate cose imbarazzanti o illegali”.

——————–

Se siete tra i miliardi di persone che negli ultimi dieci anni hanno postato foto di se stessi sui social media, potrebbe essere il momento di ripensare a questo comportamento. Una nuova tecnologia di generazione di immagini con IA, permette a chiunque di salvare una manciata di foto (o fotogrammi di video) di voi, per poi addestrare l’IA a creare foto false realistiche che vi mostrano mentre fate cose imbarazzanti o illegali. Non tutti possono essere a rischio, ma tutti dovrebbero saperlo.

Le fotografie sono sempre state soggette a falsificazioni, prima nelle camere oscure con forbici e pasta e poi con Adobe Photoshop attraverso i pixel. Ma ci voleva una grande abilità per renderle convincenti. Oggi, creare falsi fotorealistici convincenti è diventato quasi banale.

Una volta che un modello IA impara a rappresentare una persona, la sua immagine diventa un gioco del software. L’IA può creare immagini di queste persone in quantità infinite. E il modello di IA può essere condiviso, consentendo anche ad altre persone di creare immagini di quella persona.

John: un caso di studio sui social media

Quando abbiamo iniziato a scrivere questo articolo, abbiamo chiesto a coraggiosi volontari se potevamo usare le loro immagini sui social media, per tentare di addestrare un modello di IA a creare falsi. Hanno accettato, ma i risultati erano troppo convincenti e il rischio di reputazione troppo grande.

Abbiamo quindi utilizzato l’intelligenza artificiale per creare una serie di sette foto simulate sui social media, relative ad una persona fittizia che chiameremo “John”. In questo modo, possiamo mostrarvi con sicurezza i risultati. Per ora, facciamo finta che John sia una persona reale. Il risultato è esattamente lo stesso, come potete vedere qui sotto.

Queste immagini inoffensive, in stile social media, di “John” sono state usate come dati di addestramento che la nostra IA ha utilizzato per metterlo in posizioni più compromettenti. (fonte)

Utilizzando solo queste sette immagini, si potrebbe addestrare l’intelligenza artificiale a generare immagini che facciano sembrare che John abbia una vita segreta. Ad esempio, potrebbe piacergli scattare selfie nudi nella sua classe.

Di notte, John potrebbe andare nei bar vestito da clown. Nei fine settimana potrebbe far parte di un gruppo paramilitare estremista. E forse ha scontato una pena detentiva per un’accusa di droga illegale, ma l’ha nascosto al suo datore di lavoro.

Abbiamo usato un generatore di immagini di IA chiamato Stable Diffusion (versione 1.5) e una tecnica chiamata Dreambooth per insegnare all’IA come creare immagini di John in qualsiasi stile. Anche se il nostro John non è reale, qualcuno potrebbe riprodurre risultati simili con cinque o più immagini di qualsiasi persona. Potrebbero essere estratte da un account di social media o anche prese come fotogrammi da un video.

Il processo di addestramento, per insegnare all’IA a creare immagini di John, ha richiesto circa un’ora ed è stato gratuito grazie a un servizio di cloud computing di Google.

Una volta completato l’addestramento, la generazione delle immagini stesse ha richiesto diverse ore, non perché la generazione sia lenta, ma perché abbiamo dovuto passare in rassegna molte immagini imperfette (e usare la tecnica del “trial-and-error”) per trovare le migliori.

Tuttavia, è molto più facile che tentare di creare da zero un falso realistico di “John” in Photoshop.

David Icke: Intelligenza Artificiale e Super-Razza. Cosa disse anche Stephen Hawking prima di morire

Grazie all’intelligenza artificiale, possiamo far sembrare che John commetta atti illegali o immorali, come introdursi in una casa, usare droghe illegali o fare la doccia nudo con una studentessa.

Con l’aggiunta di modelli di intelligenza artificiale ottimizzati per la pornografia, John può diventare una pornostar e questa capacità può persino sconfinare nel territorio del CSAM [ Child Sexual Abuse Material)].

Possiamo anche generare immagini di John che fa cose apparentemente innocue ma che potrebbero comunque essere devastanti per lui: bere in un bar quando si è impegnato alla sobrietà o passare del tempo in un posto dove non dovrebbe essere.

Può anche essere messo in situazioni divertenti e fantastiche, come essere un cavaliere medievale o un astronauta. Può apparire giovane o vecchio, obeso o magro, con o senza occhiali o apparire con abiti diversi.

Le immagini sintetizzate non sono perfette. Se si guarda con attenzione, una persona esperta può riconoscere che si tratta di falsi. Ma la tecnologia che crea queste immagini è progredita rapidamente e presto potrebbe essere del tutto impossibile distinguere una foto sintetizzata da una vera.

Tuttavia, anche con le loro carenze, ognuna di queste immagini false potrebbe insinuare dubbi devastanti su John o potenzialmente rovinare la sua reputazione.

Si possono vedere molti esempi di persone che utilizzano questa stessa tecnica (con persone reali) per creare foto profilo stravaganti e artistiche di se stessi. E di recente sono nati servizi commerciali e app come Lensa che promettono di gestire la formazione al posto vostro.

Quello che non mostrano, sono i potenziali effetti negativi di questa tecnologia se una persona usa il volto di qualcun altro senza il suo consenso.

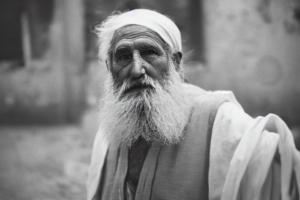

Questa “foto” dell’antico filosofo greco Eraclito, generata dall’intelligenza artificiale, si basa su ciò che il modello di intelligenza artificiale sa sulle foto di uomini anziani e sulle rappresentazioni della cultura greca antica che sono state trovate nel suo set di dati nell’ addestramento. (fonte)

Come funziona?

Se non avete prestato attenzione ai rapidi progressi dei generatori di immagini IA negli ultimi tempi, vedere quello che abbiamo realizzato qui sopra potrebbe essere molto allarmante. In pratica, gli scienziati informatici hanno scoperto come generare nuove immagini fotorealistiche di qualsiasi cosa si possa immaginare, insegnando all’IA a usare foto reali, e la tecnologia ha subito una rapida accelerazione nell’ultimo anno.

La tecnologia è stata controversa perché, oltre alle foto, ha permesso di generare nuove opere d’arte che imitano il lavoro di artisti esistenti senza il loro permesso.

Uno dei generatori di immagini IA di maggior impatto si chiama Stable Diffusion. Si tratta di un modello di sintesi di immagini ad apprendimento profondo (un termine elegante per indicare un software di intelligenza artificiale) in grado di generare immagini completamente nuove a partire da descrizioni testuali.

Può essere eseguito localmente su un PC Windows o Linux con una GPU potente, su un Mac o nel cloud su hardware a noleggio.

Con il sostegno finanziario di Stability AI, un’organizzazione accademica chiamata CompVis ha addestrato il modello di IA di Stable Diffusion utilizzando centinaia di milioni di immagini accessibili al pubblico e scaricate da Internet.

Stability AI ha rilasciato Stable Diffusion come software open source il 22 agosto 2022, il che significa che chiunque può utilizzarlo gratuitamente, ed è stato integrato in un numero crescente di prodotti commerciali.

Con un intenso addestramento, la rete neurale di Stable Diffusion ha imparato ad associare le parole e l’associazione statistica generale, tra le posizioni dei pixel nelle immagini.

Di conseguenza, è possibile dare a Stable Diffusion un input di testo, ad esempio “Morgan Freeman in un’aula”, e si otterrà un’immagine completamente nuova di Morgan Freeman in un’aula.

Creare immagini di Morgan Freeman è facile perché probabilmente ci sono centinaia di sue foto nel set di dati utilizzato per addestrare Stable Diffusion. Sa già che aspetto ha Morgan Freeman. Ma se si vuole che crei immagini di una persona comune come John, è necessario dare a Stable Diffusion un aiuto in più.

È qui che entra in gioco Dreambooth. Annunciato il 30 agosto 2022 dai ricercatori di Google, Dreambooth utilizza una tecnica speciale per insegnare al modello IA di Stable Diffusion, nuovi soggetti mediante un processo chiamato “fine tuning“.

Inizialmente, Dreambooth non aveva nulla a che fare con Stable Diffusion e Google ha trattenuto il codice di Dreambooth per timore di un uso improprio (come abbiamo mostrato qui). Ma non molto tempo dopo il suo annuncio, qualcuno ha adattato la tecnica Dreambooth per lavorare con Stable Diffusion e ha rilasciato il codice liberamente come progetto open source.

Da allora, Dreambooth è diventato un modo popolare per gli artisti dell’intelligenza artificiale di insegnare a Stable Diffusion nuovi stili artistici (o su prodotti come le scarpe), e condividono i loro modelli sintonizzati su Dreambooth in repository online. Altri artisti li scaricano e possono utilizzare il precedente addestramento Dreambooth per ottenere effetti simili.

C’è qualcosa che possiamo fare?

Al momento è possibile provare a mettere tutte le foto offline. Forse è una buona idea. Ma per alcune persone, come politici o personaggi pubblici, non è possibile. E in altri casi, gli amici potrebbero aver pubblicato foto di voi in contesti di gruppo al di fuori del vostro controllo.

In futuro, potrebbe essere possibile proteggersi da questo tipo di abuso fotografico con mezzi tecnici. Ad esempio, i futuri generatori di immagini con IA potrebbero essere obbligati per legge a incorporare filigrane invisibili nei loro prodotti, in modo che possano essere letti in seguito e le persone sappiano che si tratta di falsi.

Ma le persone dovranno essere in grado di leggere facilmente le filigrane (ed essere istruite sul loro funzionamento) perché questo abbia un qualche effetto. Ma avrà importanza se una foto falsa e imbarazzante di un ragazzo condivisa con un’intera scuola ha una filigrana invisibile? Il danno sarebbe già stato fatto.

Stable Diffusion incorpora già i watermark [filigrana elettronica] per impostazione predefinita, ma chi utilizza la versione open source può aggirare l’ostacolo rimuovendo o disattivando la componente watermarking del software. E anche se le filigrane sono obbligatorie per legge, esisterà comunque la tecnologia per produrre falsi senza filigrana.

Stiamo facendo delle ipotesi, ma un altro tipo di filigrana, applicata volontariamente alle foto personali, potrebbe essere in grado di interrompere il processo di formazione di Dreambooth. Di recente, un gruppo di ricercatori del MIT ha annunciato PhotoGuard, un processo avversario che mira a interrompere e impedire all’IA di manipolare una foto esistente modificando sottilmente la foto con un metodo invisibile. Al momento, però, è rivolto solo all’editing dell’IA (spesso chiamato “inpainting”), non all’addestramento o alla generazione di immagini.

Un altro potenziale antidoto è il tempo. Con l’aumentare della consapevolezza, la nostra cultura potrebbe alla fine assorbire e mitigare questi problemi. Potremmo accettare questo tipo di manipolazione come una nuova forma di realtà mediatica di cui tutti devono essere consapevoli.

La provenienza di ogni foto che vediamo diventerà molto più importante; come oggi, dovremo fidarci completamente di chi sta condividendo le foto per credere a una qualsiasi di esse. Ma in un periodo di transizione, prima che tutti siano consapevoli di questa tecnologia, i falsi sintetici potrebbero causare un certo caos.

Sebbene sia una tentazione pensare che il nostro senso della realtà mediatica – anche se attualmente mal riposto – possa subire un colpo mortale per mano della fotografia sintetica, molte persone sanno già di essere scettiche nei confronti di foto che potrebbero essere manipolate o estrapolate dal contesto.

Tuttavia, tendiamo a credere alle prove quando queste supportano ciò che vogliamo credere. In questo senso, non è cambiato nulla se non la scala e la velocità con cui i falsi possono avvenire.

fonte: https://arstechnica.com/information-technology/2022/12/thanks-to-ai-its-probably-time-to-take-your-photos-off-the-internet/

traduzione: M.Cristina Bassi per www.thelivingspirits.net